Pod wieloma względami, historia SEO przypomina historię samego Internetu, jak również rozwijających się wyszukiwarek internetowych. Na gruncie nieprzyjaznych użytkownikom interfejsów, ewoluował skomplikowany koncept optymalizacji witryn. Optymalizacji, która zakłada maksymalną dostępność i przydatność domeny dla użytkowników. Nie zawsze tak było. Zobacz, jak zmieniało się podejście do pozycjonowania stron na przestrzeni lat.

- Jaką datę możemy uznać za początek SEO?

- „Dawniej SEO było prostsze”

- Niedoskonały algorytm wyszukiwarki?

- Różnice pomiędzy Black i White Hat SEO – czyli jak dawniej uzyskiwało się szybkie efekty w pozycjonowaniu

- Jak działa algorytm dzisiaj?

- Ale czym tak naprawdę są i jak działają aktualizacje Google

- Czynniki rankingowe Google

- Linkbuilding to 30% sukcesu – optymalizacja 70%

- Niedozwolone linki w SEO

- Aktualizacja która zmieniła linkowanie w SEO

- Content marketing – domena jako nośnik treści

- Treści czy „treści”?

- Nowoczesna forma budowania contentu

- Rewolucja w dziedzinie content marketingu

- SEO za efekty czy SEO z podejściem holistycznym?

- W jaką formę SEO zainwestować?

- Czy etyczne SEO jest możliwe

W zasadzie, aby przyjąć porządek chronologiczny, należałoby odnotować, że wraz ze wzrostem popularności Google, na pierwszym miejscu zawsze stało tylko i wyłącznie pozyskiwanie klientów oraz reklama, nawet kosztem deformacji własnej strony internetowej (pod względem designu, treści, itp. – robiono wszystko, aby na witrynie znalazło się jak najwięcej fraz kluczowych).

W jaki sposób zatem, działania i aktualizacje Google ujednoliciły system optymalizacji? Jak wpłynęło to na postępowanie marketerów i pozycjonerów? Jakie ważne zmiany dotknęły te branże? Jak czynniki rankingowe Google wpłynęły na unowocześnienie sposobu tworzenia witryn? W jaki sposób „powstanie” SEO zmieniło technikę budowania strategii marketingowych? Czego nauczyli się użytkownicy korzystający z wyszukiwarki? A wreszcie, jak bardzo SEO dzisiaj ma wpływ na ich wyszukiwanie oraz składnię wpisywanych zapytań (fraz kluczowych)? Aby odpowiedzieć na te i więcej pytań, musimy zacząć od podstaw.

Jaką datę możemy uznać za początek SEO?

Teoretycznie, można przyjąć, że SEO (Search Engine Optimization) w swojej bardzo pierwotnej formie, zaczęło funkcjonować w momencie powstania pierwszej strony internetowej, a mianowicie w 1991 roku. Jednak prawdziwy sens, zyskało dzięki uruchomieniu przeglądarek internetowych, czyli pomiędzy rokiem 1993 (wtedy na arenę wkroczył Excite, wstępnie jako Architext1), poprzez 1994 (powstało Yahoo! – chociaż domena została zarejestrowana w 1995 r.2), kończąc na 1996, kiedy na Uniwersytecie Stanford, w głowach dwóch studentów, Larry’ego Page’a i Sergeya Brina, zaistniał pomysł na algorytm wyszukiwania, zwany… BackRub. Spodziewałeś się tutaj nazwy Google? To dobrze, bo właśnie na podstawie BackRub, w 1997 roku stworzono i zarejestrowano domenę Google.com3. I to w oparciu o tę ostatnią historię lub historię zmian w algorytmie wyszukiwania, jesteśmy w stanie porównać sposoby działania SEO na przestrzeni lat. Nie da się ukryć, że powstanie Google, zmieniło na zawsze strategię tworzenia i funkcjonowania nie tylko witryn w Internecie, ale również poruszania się po nich użytkowników.

Kiedy zatem możemy przyjąć umowną granicę, pomiędzy „starym”, a „nowym” SEO? Jakie znaczące zmiany w algorytmie wyszukiwarek wywróciły sposób optymalizacji domen do góry nogami?

„Dawniej SEO było prostsze”

Najogólniej ujmując, SEO na samym początku, było po prostu mniej skomplikowane. Zasady były proste i obejmowały zaledwie parę sfer działania witryn internetowych. Nie poruszały kwestii optymalizacji treści, nagłówków, czy użyteczności domeny dla użytkowników, a tym bardziej szybkości ładowania się, co aktualnie wydaje się wręcz przymusowym działaniem, jeśli chcemy osiągać wysokie pozycje w Google. Oczywiście, skromne optymalizacje, podyktowane były jeszcze raczkującą w tamtych czasach, dziedziną Web Designu. Niemniej, brak kontroli ze strony Google nad czymkolwiek związanym z optymalizacją, samowolka kreatorów stron internetowych oraz tworzenie spamerskich linków, dały szerokie pole do nadużyć w temacie SEO. Ówcześni marketerzy, aby osiągnąć najlepszą widoczność w dopiero co raczkującej wyszukiwarce, musieli korzystać głównie z umiejętności spekulowania i zacierania śladów, aniżeli dostosowywania witryn pod jakąkolwiek użyteczność.

Niestety, takie działania ze strony klientów Google, powodowały, że jego użytkownicy, nie otrzymywali precyzyjnych odpowiedzi na zadawane przez siebie pytania. Brak kontroli nad tym wszystkim po stronie wyszukiwarki, powodował, że była ona w początkach swojego funkcjonowania mało przydatna komukolwiek. Rozpoczęto więc prace nad aktualizacją algorytmu, które nagradzałyby jakość i szerzenie na witrynach zgodnych z prawdą informacji, jak również przydatność pod względem użytkownika. Dzięki temu starano się zachęcić odbiorców do korzystania z Google.

Pisząc „odbiorców”, mam na myśli zarówno twórców witryn, jak również osoby poszukujące odpowiedzi na tych witrynach. Chodziło o to, aby łączyć domeny z użytkownikami, którzy szukali na nich niepodważalnych odpowiedzi. Od tego czasu, SEO bardzo ewoluowało, zmuszając e-marketerów, do upatrywania alternatywnej strategii szybkiego osiągania dobrych wyników. To krótkie streszczenie nauczyło nas przed wszystkim (i to powinien być najistotniejszy wniosek na kolejne lata), że w kontekście pozycjonowania, najlepszym sposobem na przygotowywanie się na nadchodzące zmiany, nigdy nie może być chodzenie na skróty. Google rok za rokiem wykluczało z indeksu witryny, próbujące oszukać algorytm.

Niedoskonały algorytm wyszukiwarki?

Zaczynając od podstaw: algorytm wyszukiwarki to złożona struktura matematyczna, która tłumaczy komputerom i urządzeniom mobilnym, jak mają wyszukiwać. Można ogólnie ująć i raczej nie będzie to kontrowersyjne stwierdzenie, że nie do końca wiadomo, jak algorytm działa i na jakich danych bazuje. Ma on za zadanie dobierać strony internetowe, które znajdą się w indeksie na określonych pozycjach. Chociaż Google udostępnia pokaźną listę czynników rankingowych, na podstawie których ocenia on witryny, to nie zawsze teoria idzie w parze z praktyką, co wywołuje wiele spekulacji. Po wpisaniu przez użytkownika frazy kluczowej, algorytm przemierza jak największą liczbę stron i przypisuje do nich określoną rangę ważności. Strony będące odpowiedzią na wyszukiwane frazy, a zarazem odpowiednio dostosowane do wymagań algorytmu, mają szansę pojawić się najwyżej w wynikach wyszukiwania. Szacuje się, że Google uaktualnia algorytm prawie 500 razy do roku, wliczając w to bardzo małe i większe poprawki.

Podążanie za trendami SEO wytyczonymi przez algorytm jest bardzo trudne i pracochłonne. Jednak bardzo ważne jest, aby pozostać w temacie, ponieważ od czasu do czasu, Google wprowadza ogromne aktualizacje, których efekty są odczuwalne na wielu stronach internetowych. Wielokrotnie zmiany te powodują nagłe spadki lub wzrosty widoczności (nad czym akurat nikt nie płacze) i inne zamieszania w indeksie. Co ważne, Google nie o wszystkich zmianach informuje na bieżąco lub przed realizacją. Systematycznie pozycjonerzy otrzymują wiadomości po czasie, czego efektem są najczęściej raptowne spadki w widoczności serwisów, które trudno logicznie wyjaśnić.

Mimo wszystko, co sprytniejsi webmasterzy i SEOwcy, niekiedy nauczyli się panować nad zmianami i obracać je na swoją korzyść. Przez to, algorytm był skłonny do wielu nadużyć z ich strony, o czym zostanie wspomniane w późniejszych akapitach. Stąd aktualizacje algorytmu nakierowane są nie tylko na poprawę jakości wyszukiwań, ale również na walkę z nieuczciwością. Aby nie było problemu ze stwierdzeniem, jakie działania są zgodne z wytycznymi Google, a jakich nie powinno się stosować w obawie przed nałożeniem na domenę filtra, ukuto terminy: White Hat SEO oraz Black Hat SEO, które bezpośrednio nawiązywały do westernowych postaci: dobrego i złego, noszących charakterystyczne kontrastowe kapelusze4.

Różnice pomiędzy Black i White Hat SEO – czyli jak dawniej uzyskiwało się szybkie efekty w pozycjonowaniu

Eksperci wpadli na pomysł tych terminów, aby odróżnić niechciane, od wskazanych praktyk optymalizacyjnych SEO. Stosowanie się do działań znajdujących się na liście Black Hat SEO, mogło i może skutkować nałożeniem na domenę przez wyszukiwarkę bana lub filtra na określoną frazę, grupę fraz kluczowych, podstronę bądź całą witrynę. Natomiast działania z zakresu White Hat SEO, są mile widziane w procesie optymalizacji witryny. Aktualnie niespecjalnie stosuje się już te terminy, odeszły one trochę w niepamięć. Głównie dlatego, że zwiększyła się świadomość marketerów i pozycjonerów odnośnie optymalizacji, a skuteczność wyszukiwarki w odnajdywaniu domen niestosujących się do wytycznych i próbujących oszukać algorytm, jest zaskakująco dobra.

W skrócie można stwierdzić, że praktyki Black Hat SEO nakierowane są głównie na wyszukiwarkę, a nie na użytkownika. Stosuje się je najczęściej, aby oszukać algorytm lub naprawić szybko jakąś sytuację, np. nagłe spadki. Techniki Black Hat SEO są bardzo kuszące i w pierwszym momencie najczęściej skuteczne, jednak krótkoterminowo. Zdecydowanie niosą ze sobą bardzo dużo ryzyka, ponieważ dla każdego użytkownika witryny te nie mają żadnej wartości i to zazwyczaj już na pierwszy rzut oka. Do najczęstszych praktyk w zakresie Black Hat SEO, należą np.: ukrywanie treści przesadnie przepełnionej frazami kluczowymi, spamowanie linkami zewnętrznymi, ukrywanie linków na stronie, wdrażanie tzw. chmury tagów. Jedyne, co na pewno oferują techniki Black Hat SEO, to niestabilne efekty w pozycjonowaniu.

White Hat SEO natomiast nakierowane jest na użytkownika, ale również w jakimś procencie na wyszukiwarkę – wszakże to dzięki niej użytkownik w ogóle znajdzie się na stronie. Dobre praktyki SEO obejmują między innymi: stosowanie trafnie dobranych fraz kluczowych, budowanie wartościowego zaplecza linków zwrotnych, wdrażanie unikalnych meta tagów, nagłówków, treści i zwracanie uwagi na wysoką użyteczność witryny dla użytkownika.

Jak działa algorytm dzisiaj?

Aby odpowiedzieć na to pytanie, trzeba wyjaśnić pokrótce, jak bardzo zmienił się proces optymalizacji domen w ogóle. Unaoczni to bowiem, w jaki sposób musiały one zostać dostosowane do aktualizacji algorytmu i czasów, w których żyjemy, czyli tytułowego „dziś”.

Prawdą jest, że dawniej optymalizacja strony internetowej przebiegała w dość prosty sposób. Bazując głównie na wspomnianych wyżej praktykach Black Hat SEO (do których robot Google nie przywiązywał aż takiej uwagi, to znaczy nie były one wówczas niedozwolone) oraz po przeczytaniu paru mniej ważnych publikacji odnośnie SEO, można było zoptymalizować witrynę własnymi siłami. Proces ten nie wymagał od osoby zbyt wielu konkretnych umiejętności. Dzisiaj nazwalibyśmy to parodią optymalizacji, za którą z pewnością strona internetowa otrzymałaby bana od Google. W związku z tym, że algorytm wykorzystywał słowa kluczowe do określania pozycji w rankingu wyszukiwarki, wszystko opierało się na wspomnianym już tutaj upychaniu gdziebądź fraz kluczowych, nierzadko po przecinku i w bardzo widocznych miejscach. Im więcej fraz kluczowych, tym bardziej widoczna stawała się na nie domena. Proste, prawda? Nie robiono sobie nic z czytelności, użyteczności i przejrzystości witryny, na co aktualnie zwraca się niemałą uwagę.

Ale czym tak naprawdę są i jak działają aktualizacje Google

Wraz ze wzrostem ilości witryn w indeksie, Google zaczęło dostrzegać problem z jakością niektórych domen, które nie przynosiły użytkownikom odpowiedzi na zadawane pytania. Zaczęto wprowadzać szereg ulepszeń – aktualizacji, mających rozróżnić witryny wartościowe, od tych nieprzydatnych. Ogólną dynamizację algorytmu można przyrównać do rozwoju sztucznej inteligencji. Od niedoskonałego urządzenia, do narzędzia rozumiejącego treść, odczytującego content jako całość, a nie szereg powtarzających się fraz kluczowych. Google, wprowadzając te aktualizacje, nie tylko narzuciło sposób działania webmasterom, webdesignerom, czy pozycjonerom, ale również nauczyło użytkowników zadawać w oknie wyszukiwarki odpowiednie pytania. Sposób wprowadzania treści, zaczął rzutować na to, co właściciele domen postanowili umieszczać w opisach na stronie i meta tagach.

Idealnym tego przykładem może być umieszczanie w meta title sformułowania „near me”, które pojawiło się i wiodło prym głównie w anglojęzycznej wersji wyszukiwarki. Wraz z rozwojem funkcji wyszukiwania głosowego na smartfonach, naturalnym dla użytkowników stało się poszukiwanie konkretnych miejsc znajdujących się najbliżej, np. restauracji, sklepów i innych punktów obsługi. Używali do tego określenia „near me” – oznaczającego „niedaleko mnie”, np. „restaurant near me”. Wprowadzanie go do opisów meta, rozwinęło nieco optymalizację SEO nakierowaną na wyszukiwanie lokalne. Działo się tak pomimo tego, że w pierwszej kolejności, potencjalnemu klientowi i tak bardziej zależało na znalezienia czegoś na mapce Google, która niemal zawsze przy wyszukiwaniu lokalnym, wyświetla się jako pierwsza, na szczycie listy wyszukań.

Czynniki rankingowe Google

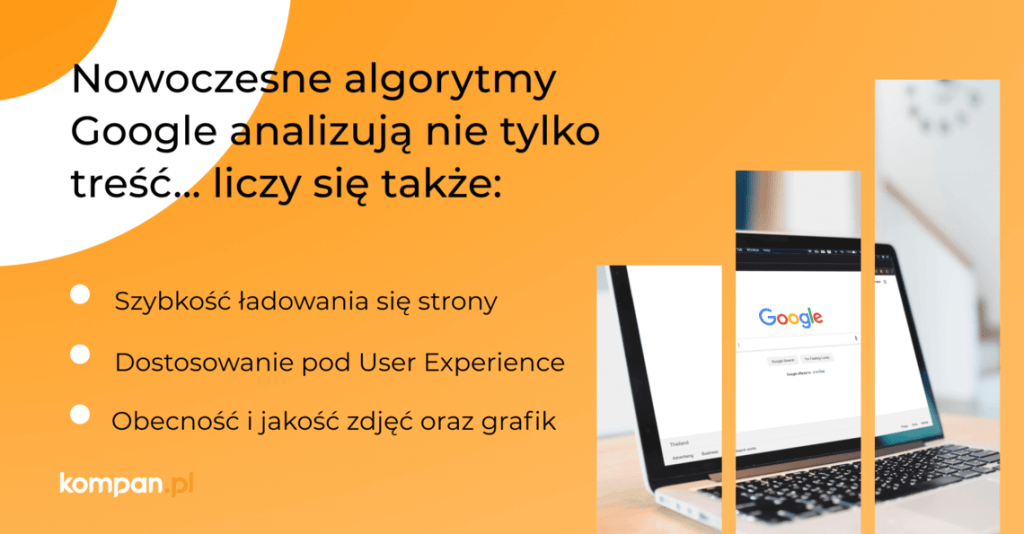

Narzucanie przez wyszukiwarkę kolejnych zmian, prowadziło do tego, że nieaktualne i przestarzałe strony WWW, zaczęły wypadać z obiegu. Algorytm z coraz większą precyzją rozpoznaje witryny niezawierające jakichkolwiek walorów informacyjnych, a zwłaszcza te nadal stosują praktyki Black Hat SEO (zdarzają się już rzadko, ale czasem ktoś próbuje je przemycić). Nowoczesne Google analizuje nie tylko treść, ale również szybkość ładowania się strony, dostosowanie jej pod kątem UX, występowanie i wyświetlanie się grafik i inne – a to wszystko zamknięto w formie listy „czynników rankingowych”, które określają to, co konkretnie może mieć wpływ na pozycję witryny w indeksie. Do najczęściej powtarzanych i znanych czynników rankingowych Google, zaliczamy:

- umieszczanie słów kluczowych w odpowiednich miejscach na witrynie (czyli nie spamowanie nimi, ale również stosowanie ich np. w opisach grafik, nagłówkach),

- formatowanie treści w taki sposób, aby była ona czytelna dla użytkowników – stosowanie nagłówków, akapitów, linków wewnętrznych, wypunktowań, itp.,

- umieszczanie tematycznych grafik, wykresów i zdjęć i prawidłowe je opisywanie w kodzie (Google interpretuje obrazy poprzez opisy ALT),

- stosowanie linkowania wewnętrznego i zewnętrznego,

- jak i gdzie mówią o domenie? Jak bardzo marka jest popularna? Jakie są o niej opinie – te umieszczane zarówno na stronie, jak i na zewnętrznych serwisach?

- responsywność – to, jak strona wyświetla się na urządzeniach mobilnych,

- szybkość ładowania się.

Jak pozostawać na bieżąco ze zmianami w algorytmie?

Aby na bieżąco uaktualniać swoją wiedzą w temacie aktualizacji algorytmu Google i nie dać się zaskoczyć zmianom, można śledzić nadchodzące informacje wieloetapowo. Poniżej parę przykładów, ułatwiających drogę do lepszego zrozumienia zasad działania algorytmu oraz zapoznawania się z podstawowymi update’ami.

- śledź popularne blogi SEO oraz liderów w branży (zarówno firmy, jak i osoby prywatne), np. moz.com, searchengineland.com, www.lexy.com.pl/blog/, papaseo.com, seoninja.pl i innych,

- bądź na bieżąco z komunikatami w Google Search Central Blog: developers.google.com/search/blog,

- śledź osobowości udzielające się na Twitterze i powiązane z Google, takie jak np.: John Mueller – twitter.com/johnmu, Danny Sullivan – twitter.com/dannysullivan

- monitoruj swoje wyniki w Google Analytics oraz sprawdzaj komunikaty w Google Search Console na bieżąco. Znaczące i nagłe odchylenia od normy w wynikach klikalności, czy wyszukiwań, mogą świadczyć o kolejnej aktualizacji (o ile nie zmieniałeś chwilę przedtem całej strony),

- monitoruj informacje na dziennikach aktywności Google, czyli w historii update’ów, np. www.searchenginejournal.com/google-algorithm-history/, moz.com/google-algorithm-change

- udzielaj się w mediach społecznościowych i ogólnopolskich lub światowych grupach branżowych SEO, gdzie dość szybko wyłapuje się bardzo mocne odchylenia od normy w widoczności serwisów, dyskutuje się o wprowadzanych przez Google nowościach oraz rozbiera kolejne aktualizacje algorytmu na czynniki pierwsze.

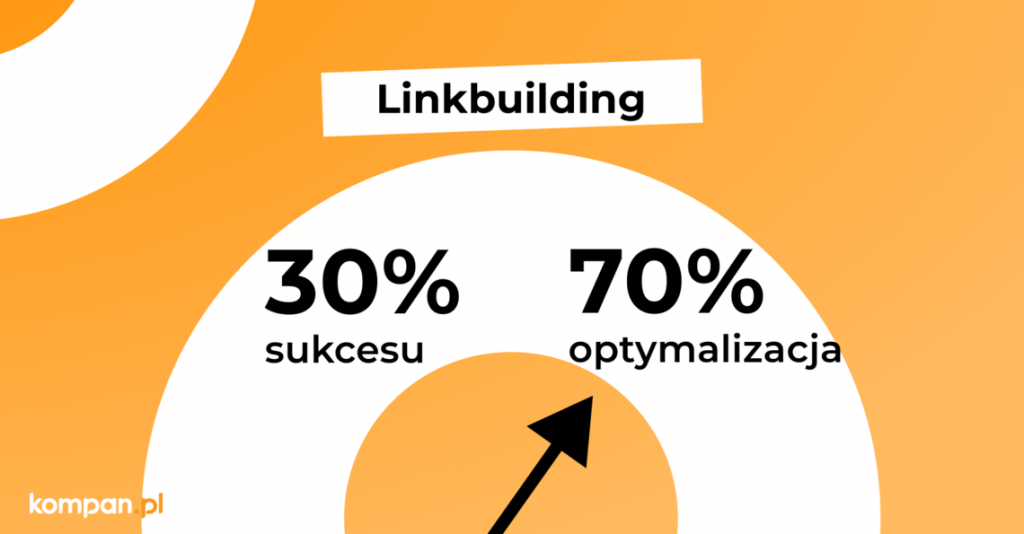

Linkbuilding to 30% sukcesu – optymalizacja 70%

W 1998 roku, krótko po wprowadzeniu na rynek wyszukiwarki, Google zaimplementowało jedną z pierwszych aktualizacji jej algorytmu. Wszystko to prowadziło do tego, aby na podstawie ilości linków prowadzących do domeny, oceniać jej wartość i przydatność użytkownikowi. Najpewniej nie przewidziano jednak, że marketerzy wykorzystują to na swoją korzyść, co doprowadziło do przespamowania witryn wtórnymi linkami.

W przeszłości każdy link, który prowadził do domeny, był linkiem dobrym i wartościowym. Wyszukiwarka nie przykładała wagi do jakości, ale do ich [linków] ilości. Budowanie zaplecza linkowego opierało się na umieszczeniu gdzie popadnie odnośników do witryn. Czy były to spamerskie fora, czy komentarze na zupełnie przypadkowych stronach www – działało niemal wszystko. Im więcej się „mówiło” o domenie, tym była ona bardziej dla wyników wyszukiwań wartościowa. Chociaż w tamtych czasach, wydawało się, że roboty wyszukiwarek nie do końca wiedziały, w jaki sposób oceniać domeny, aby promować je w swoim rankingu. Świadczy o tym chociażby fakt, że powstawały domeny z zerową wartością merytoryczną, praktycznie bez treści, ale powiązane linkami zewnętrznymi z innymi stronami, co skutkowało ich szybkim przyrostem widoczności. System ten działał i przynosił dobre efekty, więc po co SEOwcy mieliby wdrażać obszerne treści, których w ich mniemaniu i tak nikt by nie czytał? Witryny o niskiej jakości, z bezużyteczną treścią lub bez jakiegokolwiek contentu, zaczęły masowo zalewać indeks Google na przełomie wieków, a Google rozwiązywało ten problem przez najbliższe lata, utrudniając – w mniemaniu pozycjonerów – optymalizację.

Niedozwolone linki w SEO

Kolejnym sposobem zwiększającym widoczność strony i omijania wskazań Google, było linkowanie z jednego, wartościowego źródła do swojej domeny wielokrotnie (tzw. same-source links5 ). W ten sposób uzyskiwało się duplikację linków, do której w tamtych czasach, Google nie przykładało aż takiej wagi – lub nie zdawało sobie sprawy, jak bardzo system ten (potem zaczęto również duplikować treść na domenie) wpłynie na ranking. Jeśli link z jednej, wysoko ocenianej domeny podbijał widoczność tej drugiej, to czemu nie wykorzystać tego wielokrotnie? Wyobraźnia SEOwców nie znała wtedy granic.

Kiedy liczba witryn w Internecie zwiększała się na ogromną skalę, użyteczne i praktyczne stały się katalogi stron internetowych – takie ówczesne książki telefoniczne online, w których z łatwością, po kategorii, mogliśmy trafić na interesującą nas witrynę (z szukaną usługą, lokalnym produktem, kontaktem do specjalisty, itp.). Z czasem, strony te stały się przydatnym narzędziem budowania zaplecza linkowego stron internetowych. Z darmowych katalogów, tworzonych, by ułatwić użytkownikom poruszanie się po Internecie, znalazły zastosowanie jako płatne farmy linków. Chociaż później, te bardziej przezorne i zaniepokojone ewentualnymi konsekwencji wyciąganymi przez Google strony, oficjalnie lub nieoficjalnie zaczęły istnieć pod przykrywką i promowały się jako obiektywne katalogi stron internetowych. Podobnie traktowano krótkie reklamy w niskiej jakości serwisach informacyjnych, w których można było upchać dużą liczbę fraz kluczowych i niekiedy kilka linków na raz.

Popularną formą linkowania zewnętrznego, było linkowanie na tzw. anchory, czyli frazy kluczowe. Oznacza to, że nie link w formacie http:// prowadził do strony internetowej, a konkretna fraza kluczowa (np. „meble ogrodowe”). Duża liczba powtórzeń takiej frazy w formie linku, pozwalała oszukać niezorientowane jeszcze wtedy w duplikacji wyszukiwarkę. Był to również czas tworzenia narzędzi, które generowały na raz wiele linków na losowych portalach (lub takich, które były własnością „programu”), a także umieszczały ogromną liczbę komentarzy pod niepowiązanymi tematycznie artykułami bądź treściami na blogach. Liczył się po prostu link odchodzący z innej domeny.

Aktualizacja która zmieniła linkowanie w SEO

Jednak już w 2004 roku, dzięki nieco już przestarzałemu update’owi algorytmu, który nosił nazwę Brandy, Google rozpoczęło walkę z procederem spamerskiego linkowania. Najważniejszymi zmianami, które poszły za wprowadzeniem aktualizacji, były:

- zapoczątkowanie formy LSI (Latent Semantic Indexing), co prowadziło do lepszego rozumienia i rozpoznawania wyrazów bliskoznacznych, czyli dopasowania semantycznego – dzięki temu, wyszukiwarka lepiej rozpoznawała koncepcję i temat strony internetowej. Im bardziej bliskoznaczne frazy kluczowe umieszczano obok siebie w treści na stronie, tym – zdaniem Google – następowała lepsza odpowiedź na zadane przez użytkownika pytanie; pod lupę wzięto kontekst treści6,

- zmiany dotknęły również przede wszystkim URLe – od 2004 roku, anchory swoją treścią miały nawiązywać do tematyki linku, do którego prowadziły,

- ukuto również termin „Neighborhood”, dotyczący sąsiedztwa linków7. Jeśli do strony o określonej tematyce, prowadziły linki np. z for, blogów, artykułów branżowych lub powiązanych merytorycznie, to wszystkim tym domeną przypisywano tzw. sąsiedztwo. Google chciało zacząć karać witryny, które posiadały wiele przypadkowych linków zewnętrznych, niepowiązanych tematycznie. Dzięki temu, wyszukiwarka miała stać się bardziej wydajna i przekazywać prawdziwe informacje użytkownikom.

Niestety to, czy wprowadzenie tej aktualizacji algorytmu miało realny wpływ na ocenę jakości witryn, nie było do końca jasne. Na pewnym forum, oficjalnie lub nieoficjalnie, człowiek o nicku GoogleGuy potwierdził jednak, chociaż zrobił to dość enigmatycznie, że update ten jak najbardziej prowadził do rozwoju jakości wyszukiwań Google8.

Content marketing – domena jako nośnik treści

Nie da się ukryć, że content marketing, jako narzędzie do promocji, jest o wiele starszą formą reklamy, niż pozycjonowanie. Jednak w momencie „powstania” SEO, treść niemal natychmiast stała się nieodzownym i ważnym jego elementem. Można stwierdzić, że pozycjonowanie niejako przywłaszczyło sobie siłę content marketingu i wykorzystało ją na swój własny użytek. Chociaż i jednej, i drugiej formie reklamy przyświecał ten sam cel – pozyskać klienta. Być może ta koncepcja stała się najważniejszym punktem wspólnym w relacji SEO – treść i w takiej formie pozostała tak samo istotna do dziś.

Za jeden z ważniejszych momentów rozkwitu marketingu treści, można uznać rozwój sfery blogowej. W 2002 roku wręcz trendem stało się posiadanie bloga, a twórcy zaczęli realnie zarabiać na swoich treściach, np. przy pomocy BlogAds – matki wszystkich platform, na których spienięża się treści reklamowe. Kiedy w 2003 roku, Google wypuściło własną wersję – Google AdSense, nastąpiło kolejne ożywienie w branży9. Pojawiły się różne style blogowania, artykuły stały się bardziej sprecyzowane i podejmujące fachowe tematy. Twórcy i użytkownicy niszowych specjalizacji zaczęli tworzyć sieć kontaktów. Ludzie podejmowali próby zamiany hobby w karierę. Po czasie zaczęły pojawiać się kontrakty reklamowe, rozwinął się system poleceń, marketing szeptany. Wartość reklamowanego produktu zaczęła być mierzona wartością blogera prezentującego go (ówczesnych blogerów można uznać za proto-influencerów). Blogowanie splotło się z marketingiem treści, w którym przede wszystkim chodzi o sprzedaż. Blogi, w całej swej okazałości, stały się nośnikiem treści i reklamy jednocześnie. Jednak aby w ogóle można było je znaleźć, a reklamowany produkt miałby trafić ze swoją reklamą do potencjalnego klienta, potrzebna stała się dobra widoczność i klikalność w największej już na ten czas wyszukiwarce Google. W ten sposób, nieodzownym elementem każdej treści mającej… zostać wyszukaną, stały się frazy kluczowe.

Treści czy „treści”?

W pierwszej dekadzie XX wieku użytkownicy wyszukiwarki byli już całkiem dobrze wyszkoleni i przyzwyczajeni do formy działania fraz kluczowych oraz operowania nimi. Nie mogli oni jednak zwrócić należytej uwagi na kwestie optymalizacyjne, które powodowały, że strony osiągały wysokie pozycje na określone frazy kluczowe, dzięki czemu w ogóle można było na nie trafić. Na tych domenach natomiast, w czasach początków SEO, kiedy algorytm Google nie był jeszcze odpowiednio ukształtowany, działała zasada: „jeśli coś działa, to rób tego więcej”. Optymalizacja contentu, polegała głównie na umieszczeniu jak największej ilości fraz kluczowych, często w losowych miejscach na podstronie. Oczywiście, znajdowały się one również w opisach produktów, nagłówkach H1, H2, itp. – ale najczęściej bardziej z przypadku, aniżeli było to postępowanie prowadzone w ramach optymalizacji. Co więcej, przez te działania, dochodziło niekiedy do dużej liczby kanibalizacji fraz kluczowych. Oznacza to, że na wielu podstronach umieszczano np. takie samo, konkurencyjne i wielokrotnie zduplikowane słowo kluczowe. Robiono to często z niewiedzy, albo była to świadoma, choć rozpaczliwa próba zwiększenia widoczności wielu podstrona na raz. Przez to powstawały karykatury treści nakierowane jedynie na wzrost pozycji.

Nowoczesna forma budowania contentu

W nowoczesnej optymalizacji contentu, chodzi przede wszystkim o naturalność. Marki wszystkich branży zdały sobie sprawę, że rywalizacja na bardzo konkurencyjne frazy kluczowe, jest często nie tylko problematyczna, ale również kosztowna, co niestety nie przynosiło realnych zysków i zwiększenia konwersji. W treściach, zaczęto więc umieszczać frazy nie tylko konkurencyjne, ale również bezpośrednio odpowiadające na pytania użytkowników lub takie z długiego ogona, bardziej sprecyzowane. Zrozumiano, że osoba wpisująca w wyszukiwarkę hasło „ogrzewanie”, nie do końca jest klientem, do którego chciano trafić (pomijając w ogóle intencję wpisania takiej frazy).

Bardziej sensowne jest skierowanie się ku użytkownikowi szukającego haseł, takich jak: „ogrzewanie podłogowe do mieszkania”, „ogrzewanie pompą ciepła”, „ogrzewanie mieszkania gazem”, „jak ogrzać duże mieszkanie”, „jakie ogrzewanie się najbardziej opłaca” i inne. Właśnie te hasła zwane są potocznie „frazami z długiego ogona”. Użytkownik wpisujący je, ma na myśli zazwyczaj coś konkretnego, jest już zdecydowany na produkt lub usługę. Po wpisaniu hasła, otrzymuje niemal od razu odpowiedź, ponieważ język takich słów kluczowych jest bardziej organiczny i naturalny. Niebagatelnym profitem, ale już dla pozycjonera, jest również łatwość wypozycjonowania fraz z długiego ogona, które mają zazwyczaj nieco mniejszą wyszukiwalność, od tych konkurencyjnych.

Rewolucja w dziedzinie content marketingu

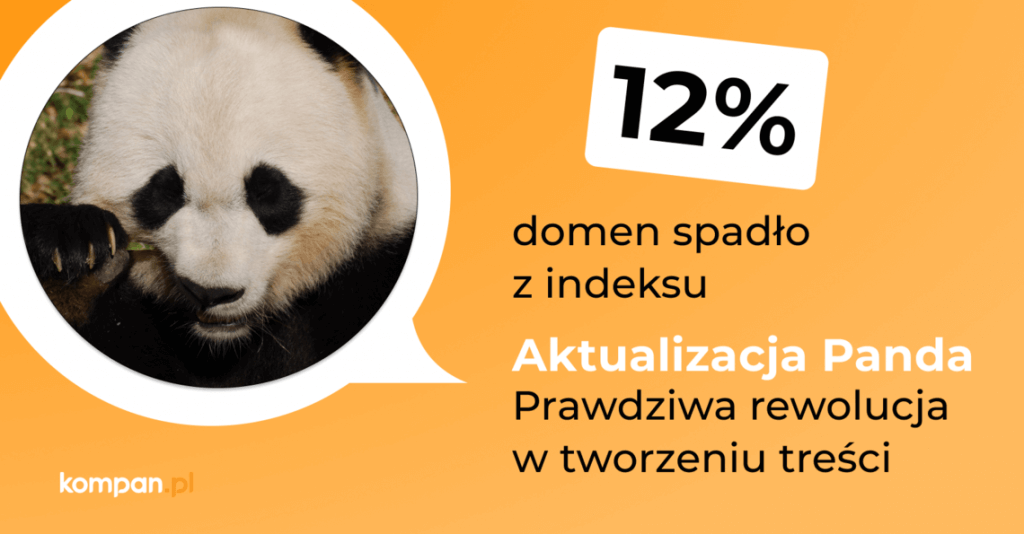

Jedną z największych rewolucji w dziedzinie contentu, Google dokonało w 2011 roku, aktualizując algorytm i uderzając bezpośrednio w treści niskiej jakości. Poważne skutki tej aktualizacji, odczuło aż 12% domen znajdujących się w indeksie10, a zmianę tę nazwano przyjaźnie „Panda”. Witryny, które posiadały wysoki współczynnik reklam w stosunku do ilości użytecznych opisów, straciły na widoczności. Zyskały natomiast domeny, które nie starały się oszukiwać algorytmu i nie stosowały nagminnie praktyk Black Hat SEO. Do tej ogromnej aktualizacji, Google przygotowało się już w 2010 roku (aktualizacja May Day), kiedy po raz pierwszy zaobserwowano na niektórych domenach duże spadki w ruchu z długiego ogona.

Wydawać by się mogło, że najbardziej ucierpiały strony właśnie z nieprzydatnym i rozwleczonym tekstem, ze sztucznie umieszczonymi frazami kluczowymi, co później zostało potwierdzone przez Matta Cuttsa11. Dość sporo czasu zajęło Google uporządkowanie spraw związanych z niskiej jakości contentem, a tak naprawdę, aktualnie i teraz można znaleźć domeny zawierające się w tym niechlubnym nawiasie. Ale niestety, tak jak w przypadku stosowania praktyk Black Hat SEO, dobre efekty mogą być tutaj krótkotrwałe.

Aktualnie, Google stoi na straży stwierdzenia, że treści na domenie mają być pisane wyłącznie pod użytkownika. Umiejętność wpasowania w nie fraz kluczowych w taki sposób, aby były jak najmniej zauważalne, stało się prawdziwą sztuką, którą ówcześni copywriterzy musieli zgłębić. Dobry content pisany pod SEO, powinien być częścią optymalizacji. Marketing treści bez SEO, jest raczej bezwartościowy, dlatego tak ważna jest synergia, w której frazy kluczowe zawsze będą działać na korzyść Twojej domeny.

SEO za efekty czy SEO z podejściem holistycznym?

Kiedyś najpopularniejszą formą rozliczania za wyniki osiągnięte w SEO, było płatność za efekt. Do dzisiaj jest ona jeszcze spotykana. Cykl ten polegał na obserwacji pozycji wybranych słów kluczowych (np. pięć, dziesięć, dwadzieścia fraz – w zależności od woli Klienta). Jeśli frazy znalazły się w TOP 10, Klient musiał za ten efekt zapłacić, a następnie za utrzymanie haseł w pierwszej dziesiątce. Reasumując, im więcej fraz kluczowych znalazło się w TOP 10, tym więcej agencja zarabiała. Wydaje się, że była to całkiem uczciwa forma rozliczania. Klient miał zawsze gotowy raport, na którym czarno na białym mógł zweryfikować pozycje. Niestety, model ten narażony był na nadużycia i miał swoje minusy, np.:

- czasem, w zależności od ustawionej lub pobranej automatycznie lokalizacji, Klient widział nieco inne pozycje, niż agencja – dlatego ważna była weryfikacja fraz np. na oknie prywatnym przeglądarki,

- agencja mogła dobrać takie frazy kluczowe dla Klienta i jednocześnie przekonała go do nich, które miały dużą szansę na znalezienie się w TOP 10 w bardzo krótkim czasie, ale ostatecznie nie przynosiły ruchu na domenie,

- wieloletnie linkowanie tych samych fraz kluczowych i prowadzenie optymalizacji tylko kilku podstron, mogło prowadzić do nałożenia filtra przez Google, bowiem działania te z czasem były uznawane za sztuczne i spamerskie, ponieważ obejmowały wąską dziedzinę i tematy – a to po wielu latach wprowadzanych aktualizacji,

- dobrze prowadzone pozycjonowanie, powinno być prowadzone długoterminowo i w sposób jak najbardziej naturalny, natomiast budowanie autorytetu strony poprzez promowanie zaledwie kilku fraz, nie dość, że przyspieszało proces pozycjonowania, to mogło wzbudzać podejrzliwość wyszukiwarki.

W jaką formę SEO zainwestować?

W prowadzeniu pozycjonowania musisz myśleć nie tylko o pozycjach fraz kluczowych, ale o wielu innych danych: współczynniku klikalności, odrzuceń, szybkości strony, responsywności, liczbie wyszukiwań, czy monitorowaniu ilości fraz kluczowych, na które widoczne jest domena. Współczesne pozycjonowanie oparte jest na (wspomnianych już tutaj wielokrotnie) naturalności i organicznym prowadzeniu linkowania, czy tworzenia unikalnych i wartościowych treści. SEO samo w sobie jest dziś trudniejsze, ponieważ na efekty czeka się zazwyczaj dłużej. Niemniej, satysfakcja jest na pewno większa. Zamiast promowania witryny na kilka bądź kilkanaście fraz kluczowych, nowoczesne pozycjonowania obejmuje prace abonamentowe, które zawierają w sobie holistyczne podejście do tematu. Na świeczniku nie jest wyłącznie osiąganie pozycji fraz na bardzo konkurencyjne hasła. Ważna jest przede wszystkim praca na frazach z długiego ogona, tj. promocja poszczególnych produktów na sklepie, a nie tylko kategorii. Istotne jest skupienie się na potrzebach użytkownika, który zadaje bardzo precyzyjne zapytania, ale również, co bardzo ważne, dostosowanie witryny do poprawnego wyświetlania jej na urządzeniach mobilnych.

Raporty za rozliczanie abonamentowe, nie skupiają się jedynie na pozycjach fraz, ale na ogólnym wzroście widoczności CAŁEGO serwisu. W przypadku pozycjonowania za efekt, optymalizacji podlegało zazwyczaj tylko kilka podstron. Tutaj natomiast, optymalizacja może zostać zaplanowana kompleksowo, a nie ułożona raz na zawsze. W nowoczesnym SEO, nie gwarantuje się szybkich i łatwych efektów. Zamiast tego, planuje się długoterminowe kampanie dostosowane do konkretnej domeny, a nie całej branży. Zdrowy, stopniowy wzrost widoczności: wyszukiwalności oraz klikalności na serwisie, jest bardziej realistycznym oczekiwaniem, niż obiecywanie wysokich pozycji na frazy, które w najgorszym wypadku mogą nawet nie przynieść ruchu na domenie. Wraz z unowocześnieniem formy pozycjonowania, zmieniły się również oczekiwania Klienta, nastawionego tym razem na wzrost ruchu oraz sprzedaży, a nie tylko niekoniecznie skutecznej promocji w wyszukiwarce.

Czy etyczne SEO jest możliwe

Google wykonało świetną robotę, porządkując w czasie wieloletniej pracy domeny w indeksie tak, aby użytkownicy mogli korzystać z wyszukiwarki w sposób zrozumiały i kompleksowy. Możliwość szybkiego znalezienia odpowiedzi na zadane pytanie, stało się kluczowym elementem życia wielu osób. „Jak zrobić ciasto?”, „Jak naprawić kran?”, „Jak wyczyścić filtr wody?” – Google codziennie procesuje miliony tym i podobnych zapytań, na których bazuje późniejsza optymalizacja. Branża SEO ewoluowała z wdrażania na domeny tanich sztuczek, do kreowania kompleksowych strategii marketingowych, których głównym celem jest wszechstronne spojrzenie na każdą witrynę. Ukonstytuowało się tym samym pojęcie „etycznego SEO”, bazującego na archaicznych już technikach White Hat SEO oraz UX, czyli User Experience (doświadczenie użytkownika korzystającego ze strony www). Ostatecznym celem Google jest nagradzanie witryn, które tworzą realnie wartościowy content. Zarówno wyszukiwarka, jak i domena korzystają przecież z tej samej bazy użytkowników, którzy potencjalnie mogą stać się klientami – czy to Google, czy sklepu internetowego.

Specjalistka ds. SEO

Kasia Cieślik

- en.wikipedia.org/wiki/Excite

- www.webdesignmuseum.org/web-design-history/yahoo-1994

- www.mirrorreview.com/history-of-google-from-1996-to-2019/

- www.searchenginejournal.com/white-hat-vs-black-hat-vs-gray-hat-seo/365142/

- support.google.com/webmasters/answer/9049606

- en.ryte.com/wiki/Brandy_Update

- takenmind.com/google-algorithm-update-2004/

- www.webmasterworld.com/forum3/21949-7-30.htm

- themeisle.com/blog/history-of-blogging/

- www.wired.com/2011/03/the-panda-that-hates-farms/

- www.seroundtable.com/archives/022293.html