Wyszukiwarka to w zasadzie baza danych miliardów stron internetowych. Jeżeli chcesz, aby Twoja domena się w niej znalazła, musi zostać odwiedzona przez robota Google, a następnie umieszczona w indeksie. Tak w skrócie można by opisać proces indeksacji witryny w wynikach organicznych.

To z pozoru proste działanie, zależne jest również od wielu czynników. Tych, które musi spełnić domena, ale również które muszą zajść pomiędzy nią, a wyszukiwarką. Dochodzi tutaj również zagadnienie crawlingu, bardzo związane z pojęciem jakim jest indeks Google. Każda z tych kwestii, zostanie rozwiązana poniżej. Zacznijmy od najważniejszych:

Czym jest Googlebot?

Googlebot to robot wyszukiwarki Google (kiedyś częściej nazywany pająkiem), który przemierza zakątki Internetu w celu skanowania domen. Podąża on za linkami, przechodząc z jednej strony na drugą, tworząc tym samym sieć zależnych od siebie domen (stąd właśnie nawiązanie do pająka). Tak mogłaby się zaczynać średniej jakości historia fantasy.

Chociaż pragnieniem Googlebota jest zdobywanie nieznanych mu wód (witryn), głównym jego zamiarem jest przetwarzanie zebranych informacji i umieszczanie ich w indeksie głównym wyszukiwarki. Ogólnie ujmując, w wynikach wyszukiwania. Googlebot wyszukuje nowe i aktualizuje stare treści zarówno na komputerach, jak i na urządzeniach mobilnych. To od Googlebota zależy, czy Twoja domena będzie widoczna w wyszukiwarce, wykorzystując swój całościowy potencjał.

Czym jest crawbility?

Pojęcie „crawbility” oznacza najogólniej pisząc „czytelność dla wyszukiwarki”. Zamiennie stosuje się pojęcie „accessibility” – co oznacza właśnie to samo. Wyszukiwarka, korzystając z usług Googlebota, czyta treści, podążą za linkami i kompleksowo skanuje witryny. To, jak bardzo Twoja domena będzie „crawbility”, jest zależne głównie od Ciebie, a co za tym idzie – od budowy strony. Im łatwiej robot Google może przeszukiwać Twoje treści, tym lepsza będzie Twoja wydajność w ramach wyników wyszukiwania – SERP.

Tak samo, jak możesz udostępnić robotowi całą domenę do indeksacji, tak samo możesz ją zablokować (np. tylko poszczególne elementy witryny). Czasem jakieś elementy strony blokują się samoistni, o czym nie zostaniesz powiadomiony. Zapory sieciowe, programy antywirusowe, a nawet Twój CMS mogą płatać figle. Od Ciebie powinno zależeć to, w jakim procencie udostępnisz robotowi swoją stronę internetową. Przy czym, podczas selekcji, zachowaj szczególną uważność, aby ważne dla Ciebie i dla użytkownika podstrony oraz zasoby domeny nie zostały przypadkiem zablokowane.

Jak działa indeksowanie?

Kiedy Googlebot, dzięki możliwościom, jakie mu zaproponujesz (crawbility), odwiedzi Twoją domenę, to zacznie się proces indeksacji poszczególnych podstron. Robot ocenia domenę na podstawie wielu parametrów, ale głównie zbiera informację o tematyce Twojej witryny. Każdy czynnik, który wyłapie Googlebot, może pomóc osiągać lepsze pozycje w rankingu wyszukiwarki.

Więcej o czynnikach rankingowych Google, przeczytasz w artykule: https://kompan.pl/blog/jaka-role-w-pozycjonowaniu-witryny-pelni-algorytm-google/

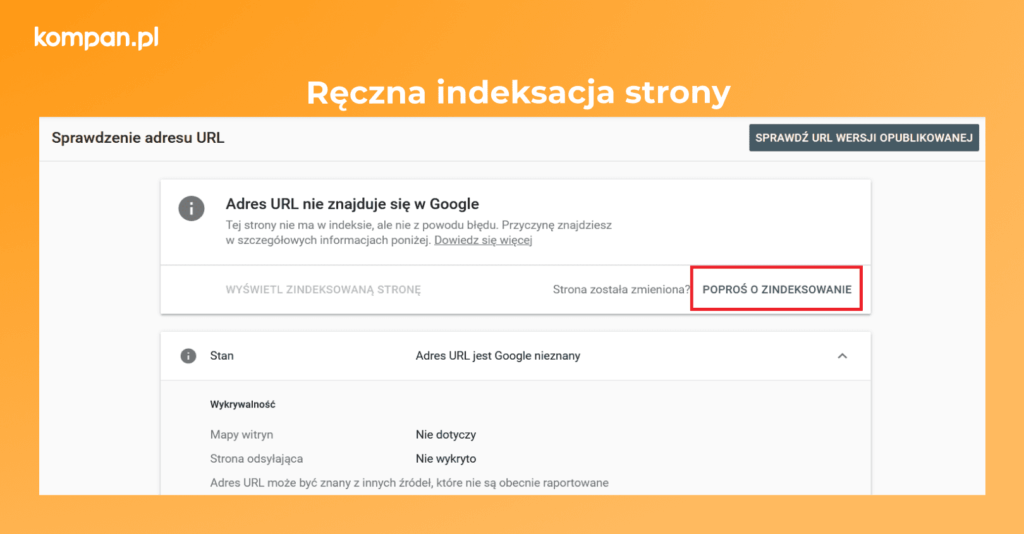

Istnieje możliwość ręcznego zaindeksowania poszczególnych podstron. Niegdyś, dzięki Google Search Console, mogliśmy indeksować nieskończoną ilość podstron (każdą z osobna), które po bardzo krótkim czasie od razu wskakiwały do indeksu. Oczywiście później podlegały one weryfikacji przez Googlebota.

Od jakiegoś czasu jednak, możemy ręcznie indeksować („poprosić o zaindeksowanie”) zaledwie parę podstron dziennie dla każdego konta. Co więcej, czas indeksacji w ciągu 15 minut również uległy wydłużeniu nawet do kilku lub kilkunastu dni. Możemy mieć szczęście i prośba o zaindeksowanie zostanie uznana dość szybko lub jeszcze szybciej, kiedy podstronę tę odwiedzi Googlebot (po wcześniejszym zaktualizowaniu mapy strony – sitemap XML). Z metody ręcznej indeksacji możemy również korzystać wtedy, gdy dokonaliśmy jakichś zmian i chcemy, aby szybciej pojawiły się w wyszukiwarce.

Skąd masz wiedzieć, które podstrony znajdują się w indeksie Google?

Najprostszą i zarazem najszybszą metodą, jest wpisanie w wyszukiwarkę komendy „site:”, po której umieszczasz nazwę domeny (bez protokołów WWW i HTTPS).

Przykład: site:kompan.pl

Dzięki temu zabiegowi, w wynikach wyszukiwania pokażą się wszystkie zaindeksowane podstrony Twojej domeny, w tym najpewniej te, których wolałbyś tam nie widzieć. Ta weryfikacja pozwoli Ci wykonać audyt linków i odfiltrować URLe do późniejszego zablokowania.

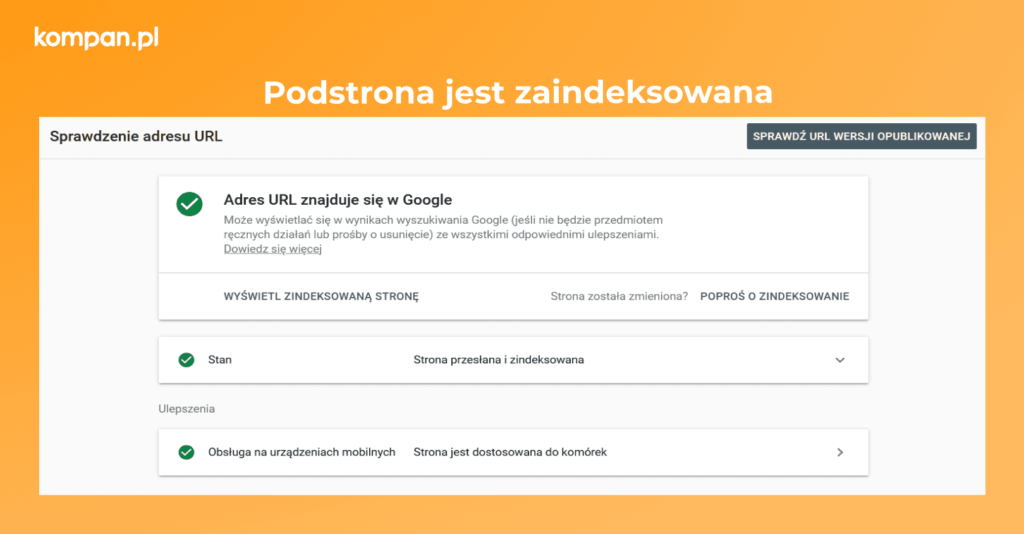

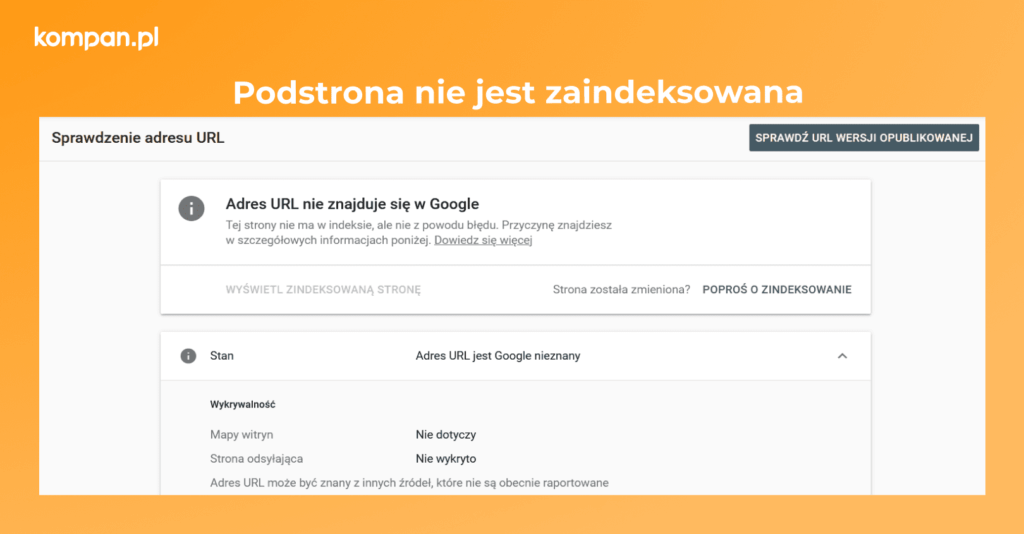

Drugą metodą weryfikacji, czy wyszukiwarka zaindeksowała konkretny link dla Twojej domeny, jest użycie Google Search Console. W tym celu musisz posiadać „konto”, uprzednio implikując kod GSC w źródło domeny. Po założeniu konta, na górnym pasku „Sprawdź dowolny URL w „tutajnazwadomeny.pl”, wpisujemy konkretny link (np. kategorii, produktu, jakiejkolwiek podstrony), który chcesz poddać weryfikacji. Następnie czekasz na odpowiedź narzędzia. Dwie odpowiedzi, jakie możesz uzyskać to:

- Podstrona jest zaindeksowana:

- Podstrona nie jest zaindeksowana:

Jak mogę zoptymalizować stronę pod dostępność – crawbility?

Poniżej przedstawiam parę krótkich punktów odnoszących się do optymalizacji strony pod dostępność robotom Google. Do każdego z tych punktów, przypisuję artykuł lub linki z informacjami poszerzający wiedzę na ten temat.

- Stwórz mapę witryny (plik sitemap.xml) na swoim serwerze lub w CMS. Jest to niejako spis treści Twojej strony, zawierający listę wszystkich podstron. Googlebot jest w stanie skorzystać z tego pliku, co ułatwi mu późniejszy crawling oraz indeksację.

Więcej poczytasz: Jak zoptymalizować mapę strony – sitemap XML?

- Stwórz plik robots.txt, w którym zawrzesz najważniejsze wskazówki dla Googlebota. Umieszczenie w nim odpowiednich komend spowoduje, że robot nie będzie poświęcał niepotrzebnego czasu na skanowaniu podstron nieistotnych dla użytkowników. Poświęci go na ważną w kontekście Twojej domeny i branży treść.

Sprawdź: Definicja pojęcia robots TXT.

- Twórz treść zarówno dla użytkowników, jak i robota Google. Najważniejsze frazy powinny być umieszczone w opisach podstron, kategorii, produktów, a wszystko to ma być czytelne dla oka. Co więcej, twórz treści NOWE – świeże i najlepiej prowadź bloga lub aktualności. Aktualizacja treści na domenie jest bardzo ceniona przez wyszukiwarkę, co procentuje najczęściej zwiększoną widocznością serwisu.

Sprawdź: Tworzysz treści na stronę? O tym musisz pamiętać

Oraz: Czym jest cloaking w SEO, czyli o ukrywaniu treści

- Używaj adresów kanonicznych i wystrzegaj się kopii podstron. Wskazuj Googlebotowi, które podstrony są tymi wiodącymi, ale nie doprowadź tym samym do sytuacji, w której poszczególne podstrony mają swoje bezużyteczne odpowiedniki. W przypadku niechcianych kopii, wybierz wersję docelową podstrony i skorzystaj z możliwości przekierowania nieaktualnego linku na drugi (przekierowanie 301). Chodzi o ogólny porządek i harmonię w linkach.

Zobacz: Jak stworzyć przyjazne adresy URL pod pozycjonowanie

- Umieszczaj w treściach linki wewnętrzne. W tym celu możesz wykorzystać opisy kategorii (nawiązując do innych kategorii lub produktów, które opisujesz), produktów (dodając np. inny polecany asortyment), a najlepiej artykuły na blogu wewnętrznym. Tym bardziej, jeśli artykuł stanie się poczytny i popularny. Wtedy możesz wykorzystać go jako źródło reklamy produktów (właśnie dodając linki wewnętrzne). Dzięki nim, Googlebot może docenić użyteczność podstrony i samemu sprawniej się po niej poruszać.

Poczytaj więcej: First link counts – czyli o linkowaniu wewnętrznym w pozycjonowaniu

- Przyśpiesz działanie strony! To bardzo ważna kwestia, której znaczenie wzrosło wraz z rozwojem sprzedaży urządzeń mobilnych. Ciągły dostęp do nowych treści, ich selekcja, tasowanie i możliwość posiadania czegoś na JUŻ, wymusiły tworzenie stron internetowych ‘accessible’ nie tylko dla użytkowników, ale i robotów. Szybkość ładowania się strony, jest aktualnie jednym z najważniejszych czynników rankingowych Google.

Zobacz: Czy szybkość ładowania serwisu wpływa na SEO

- Optymalizacja obrazów na serwisie, może wynieść widoczność Twojego serwisu na wyżyny. Dla Googlebota stanie się widoczna nie tylko treść w formie tekstu pisanego, ale również grafiki. O czym pamiętać? Przede wszystkim o opisach ALT, Title, dodatków Schema oraz o mapie grafik (tak samo, jak w przypadku linków, możemy stworzyć mapę obrazów).

Więcej informacji: Jak zoptymalizować grafiki pod SEO

- Pamiętaj również o uzupełnieniu meta tagów: title oraz description. Na początku zrób to chociaż dla najważniejszych podstron. Możesz skorzystać z funkcji automatycznego uzupełniania, o ile Twój CMS Ci na to pozwoli. Jednak podczas optymalizacji, powinieneś sukcesywnie umieszczać w nich frazy kluczowe oraz wezwania Call To Action. Dzięki uzupełnionym meta tagom, Googlebot wie, o czym jest podstrona, więc to kolejne ułatwienie mu pracy.

Sprawdź więcej na: O znaczeniu meta tagów dla pozycjonowania

Popularne czynniki które negatywnie wpływają na indeksowanie

Poniżej przedstawiam najpopularniejsze błędy na stronie, o których możesz nie wiedzieć na pierwszy rzut oka, a które negatywnie wpływają na spadek wartości crawbility. Co za tym idzie – spowalniają lub uniemożliwiają indeksowanie się podstron. Jeśli masz problemy z zaindeksowaniem się poszczególnych podstron lub jesteś pewien, że nie wszystkie podstrony są w ogóle odwiedzane przez robota Google, w pierwszej kolejności zweryfikuj tę listę:

- duplikacja treści na stronie – czyli powielanie tych samych informacji na przynajmniej dwóch podstronach,

- strony przestarzałe, wolno ładujące się i niskiej jakości,

- nieprzyjazność i nieużyteczność dla użytkowników (UX) – dotyczy zarówno całych podstron, jak i poszczególnych elementów, np. menu, opisów produktów, itp.,

- strony ładowane dynamicznie, które nie posiadają realnie istniejących linków w źródle strony,

- wiele wersji strony głównej, np. https://www.domena.pl/, https://domena.pl/ , https://domena.pl/indes.php i inne,

- długie łańcuchy przekierowań, czyli podstrony przekierowywane wiele razy: podstrona A -> podstrona B -> podstrona C,

- posiadanie spamerskich podstron bez jakiejkolwiek wartościowej treści – mowa o podstronach nieużytecznych dla klientów,

- niewłaściwe użycie tagów noindex i nofollow, które blokują dostęp Googlebota do strony oraz spowalniają indeksację,

- blokowanie robotów w pliku robots.txt.

Indeksowanie to część optymalizacji

Bez indeksowania nie byłoby jakichkolwiek wejść na Twoją domenę. Nie zwiększyłaby ona swojej widoczności, a co więcej, nie byłaby w ogóle wyszukiwania. Dlatego tak ważne jest, aby zadbać o poprawne wyświetlanie się witryny w wynikach wyszukiwania. Algorytm Google nieustannie ewoluuje, a roboty dynamicznie przeszukują sieć w poszukiwaniu zmian i nowych stron. Dlatego Twoja domena nie może wypaść z obiegu i przestać się rozwijać. Jako właściciel witryny, powinieneś upewnić się, że wszystkie linki są wolne od błędów i prześledzić proces optymalizacji witryny. W tym z pewnością pomoże Ci profesjonalna agencja SEO.

Nieważne, jak bardzo estetyczna i nowoczesna będzie Twoja strona, jeśli przez błędy wymienione powyżej, w ogóle nie będzie widoczna w wyszukiwarce. Cały proces optymalizacji powinien być na tyle spójny, że po procesie indeksacji, przyjdzie czas na zwiększanie widoczności serwisu oraz pozyskiwanie nowych klientów.